arifkarim

معطل

سیاہ فام جوڑے کی تصویر پر ’گوریلے‘ کا لیبل، گوگل کی معذرت

اس غلطی کی نشاندہی ہونے پر سوشل میڈیا پر گوگل کو تنقید کا نشانہ بنایا گیا

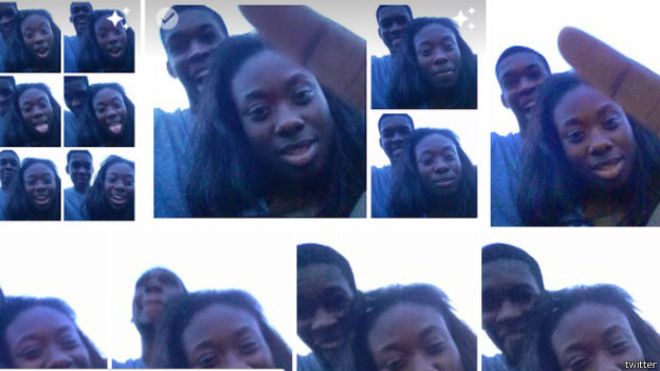

انٹرنیٹ سرچ انجن گوگل نے اپنی تصاویر کی نئی ایپلیکیشن میں غلطی پر معافی مانگی ہے جس میں ایک سیاہ فام جوڑے کی تصویر کو ’گوریلے‘ لیبل کیا گیا تھا۔

یاد رہے کہ گوگل کی یہ ایپ لوگوں کی جانب سے اپ لوڈ کی گئی تصاویر کو خودکار طریقے سے لیبل کرتا ہے۔

نیویارک کی ایک سافٹ ویئر بنانے والی کمپنی میں کام کرنے والے ایلیسن نامی ایک شخص یہ غلطی گوگل کے نوٹس میں لائے کیونکہ جس جوڑے کی تصویر کو ’گوریلے‘ لیبل کیا گیا تھا ان میں سے ایک وہ خود تھے۔

اس غلطی کی نشاندہی ہونے پر سوشل میڈیا پر گوگل کو تنقید کا نشانہ بنایا گیا۔

گوگل کے ایگزیکٹو یوناتن زنگر نے اس غلطی پر کہا: ’یہ بالکل اچھا نہیں ہوا۔ پروگرام میں اس غلطی کا خاتمہ سب سے پہلے ہونا چاہیے تاکہ آئندہ ایسا نہ ہو۔‘

انھوں نے مزید کہا کہ گوگل نے پہلے ہی ایسے قدم اٹھائے ہیں تاکہ کوئی غلطی دہرائی نہ جا سکے۔

یہ پہلا موقع نہیں ہے کہ تصاویر کی اس ایپلیکیشن نے کسی تصویر کو غلط لیبل کیا ہو۔ اس سے قبل مئی میں گوگل کی اس ایپ نے کتے کی تصویر کو گھوڑا لیبل کیا تھا۔

گوگل کی ترجمان نے بی بی سی سے بات کرتے ہوئے کہا: ’ہمیں بےحد افسوس ہے کہ ایسا ہوا۔ ہم فوری طور پر ایسے واقعات دوبارہ نہ ہونے کے لیے کام کر رہے ہیں۔‘

ترجمان نے مزید کہا: ’ایپ کی جانب سے تصاویر کو لیبل کرنے کے حوالے سے ابھی مزید کام درکار ہے اور ہم اس پہلو کو دیکھ رہے ہیں کہ ایسے واقعات دوبارہ نہ ہوں۔

تاہم ایلسن نے بی بی سی کو بتایا کہ ان کے ابھی بھی کچھ تحفظات ہیں۔

’میرے کچھ سوالات ہیں، جیسے کہ ایپلیکیشن بنانے میں کس قسم کی تصاویر اور لوگوں کو استعمال کیا گیا جس کا نتیجہ یہ نکلا۔‘

ماخذ

کیا زمانہ آگیا ہے۔ پہلے بچے جھوٹ نہیں بولتے تھے۔ اب ٹیکنالوجی جھوٹ بولنے سے انکاری ہو گئی ہے

عباس اعوان نیرنگ خیال امجد میانداد فاتح محب علوی عبدالقیوم چوہدری لئیق احمد

- 2 جولائ 2015

اس غلطی کی نشاندہی ہونے پر سوشل میڈیا پر گوگل کو تنقید کا نشانہ بنایا گیا

انٹرنیٹ سرچ انجن گوگل نے اپنی تصاویر کی نئی ایپلیکیشن میں غلطی پر معافی مانگی ہے جس میں ایک سیاہ فام جوڑے کی تصویر کو ’گوریلے‘ لیبل کیا گیا تھا۔

یاد رہے کہ گوگل کی یہ ایپ لوگوں کی جانب سے اپ لوڈ کی گئی تصاویر کو خودکار طریقے سے لیبل کرتا ہے۔

نیویارک کی ایک سافٹ ویئر بنانے والی کمپنی میں کام کرنے والے ایلیسن نامی ایک شخص یہ غلطی گوگل کے نوٹس میں لائے کیونکہ جس جوڑے کی تصویر کو ’گوریلے‘ لیبل کیا گیا تھا ان میں سے ایک وہ خود تھے۔

اس غلطی کی نشاندہی ہونے پر سوشل میڈیا پر گوگل کو تنقید کا نشانہ بنایا گیا۔

گوگل کے ایگزیکٹو یوناتن زنگر نے اس غلطی پر کہا: ’یہ بالکل اچھا نہیں ہوا۔ پروگرام میں اس غلطی کا خاتمہ سب سے پہلے ہونا چاہیے تاکہ آئندہ ایسا نہ ہو۔‘

انھوں نے مزید کہا کہ گوگل نے پہلے ہی ایسے قدم اٹھائے ہیں تاکہ کوئی غلطی دہرائی نہ جا سکے۔

یہ پہلا موقع نہیں ہے کہ تصاویر کی اس ایپلیکیشن نے کسی تصویر کو غلط لیبل کیا ہو۔ اس سے قبل مئی میں گوگل کی اس ایپ نے کتے کی تصویر کو گھوڑا لیبل کیا تھا۔

گوگل کی ترجمان نے بی بی سی سے بات کرتے ہوئے کہا: ’ہمیں بےحد افسوس ہے کہ ایسا ہوا۔ ہم فوری طور پر ایسے واقعات دوبارہ نہ ہونے کے لیے کام کر رہے ہیں۔‘

ترجمان نے مزید کہا: ’ایپ کی جانب سے تصاویر کو لیبل کرنے کے حوالے سے ابھی مزید کام درکار ہے اور ہم اس پہلو کو دیکھ رہے ہیں کہ ایسے واقعات دوبارہ نہ ہوں۔

تاہم ایلسن نے بی بی سی کو بتایا کہ ان کے ابھی بھی کچھ تحفظات ہیں۔

’میرے کچھ سوالات ہیں، جیسے کہ ایپلیکیشن بنانے میں کس قسم کی تصاویر اور لوگوں کو استعمال کیا گیا جس کا نتیجہ یہ نکلا۔‘

ماخذ

کیا زمانہ آگیا ہے۔ پہلے بچے جھوٹ نہیں بولتے تھے۔ اب ٹیکنالوجی جھوٹ بولنے سے انکاری ہو گئی ہے

عباس اعوان نیرنگ خیال امجد میانداد فاتح محب علوی عبدالقیوم چوہدری لئیق احمد